在當今高速發(fā)展的視頻流媒體行業(yè)中,愛奇藝作為中國領先的在線娛樂平臺,其業(yè)務量呈指數(shù)級增長,尤其是用戶實時行為數(shù)據(jù)、視頻播放請求等場景,對數(shù)據(jù)處理和存儲能力提出了極高要求。愛奇藝構建的實時大數(shù)據(jù)體系,成功應對了超過3000萬QPS(Queries Per Second,每秒查詢率)的峰值負載,實現(xiàn)了數(shù)據(jù)處理和存儲支持服務的穩(wěn)定性和高可用性。以下是該體系的關鍵組成部分和實現(xiàn)策略。

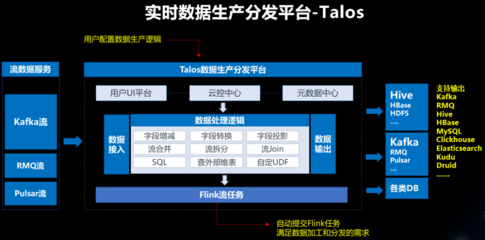

愛奇藝的實時大數(shù)據(jù)體系采用分層架構設計,分為數(shù)據(jù)采集、實時處理和存儲三個核心層面。在數(shù)據(jù)采集層,系統(tǒng)通過分布式日志收集工具(如Apache Kafka)和自定義代理,高效捕獲用戶點擊、播放、搜索等行為數(shù)據(jù),確保數(shù)據(jù)在源頭被可靠傳輸,并支持水平擴展以應對流量激增。這些數(shù)據(jù)被實時推送到處理引擎,避免了數(shù)據(jù)丟失和延遲問題,為后續(xù)分析奠定基礎。

在實時處理層,愛奇藝廣泛使用了流式計算框架,如Apache Flink和Spark Streaming。這些框架支持事件時間處理和狀態(tài)管理,能夠對海量數(shù)據(jù)進行實時聚合、過濾和關聯(lián)分析。例如,在視頻推薦場景中,系統(tǒng)可以實時計算用戶偏好,并動態(tài)調整內容推送,提升用戶體驗。通過優(yōu)化計算任務的并行度和資源調度,愛奇藝實現(xiàn)了毫秒級延遲,即使在高并發(fā)QPS下也能保持處理效率。

在存儲支持服務方面,愛奇藝采用了混合存儲策略,結合NoSQL數(shù)據(jù)庫(如HBase和Cassandra)和時序數(shù)據(jù)庫(如InfluxDB),以應對不同類型的數(shù)據(jù)需求。對于需要快速讀寫的實時數(shù)據(jù),系統(tǒng)利用分布式存儲集群提供高吞吐量和低延遲訪問;而對于歷史數(shù)據(jù),則通過數(shù)據(jù)湖(如HDFS)進行冷備份,確保長期可追溯性。愛奇藝引入了數(shù)據(jù)壓縮和索引優(yōu)化技術,減少了存儲成本,同時通過多副本機制保障數(shù)據(jù)冗余和容災能力。

為了確保整個體系的穩(wěn)定性,愛奇藝還實施了全面的監(jiān)控和自動化運維機制。通過實時監(jiān)控關鍵指標(如QPS、延遲和錯誤率),系統(tǒng)能夠快速檢測異常并觸發(fā)自動擴縮容或故障轉移。在壓力測試和實際運營中,該體系已證明其可靠性,即使在節(jié)假日或熱門內容發(fā)布期間,也能平穩(wěn)處理超3000萬QPS的流量,避免服務中斷。

愛奇藝的實時大數(shù)據(jù)體系通過先進的架構設計、高效的流式處理和靈活的存儲方案,成功應對了超大規(guī)模的數(shù)據(jù)挑戰(zhàn)。這不僅提升了平臺的服務質量,還為行業(yè)提供了可借鑒的經驗。未來,隨著5G和AI技術的普及,愛奇藝計劃進一步優(yōu)化該體系,以支持更復雜的實時場景,推動智能娛樂生態(tài)的持續(xù)發(fā)展。